Ein Zero Gap AI-Angebot Vapor IO und Vast bieten KI von der Edge über Core bis hin zur Cloud

Anbieter zum Thema

Die Software-Anbieter Vast und Plattformbetreiber Vapor IO arbeiten daran, die vielen Herausforderungen zu lösen, die mit dem Einsatz von KI-Modellen über das gesamte Kontinuum von Edge über Core bis hin zur Cloud verbunden sind. Dazu gehört, dass Vapor IO die Vast-Datenplattform als Teil seines „Zero Gap AI“-Angebots einsetzen will.

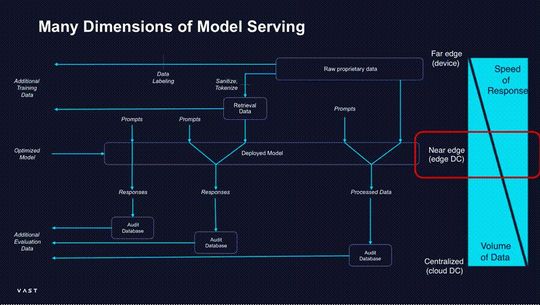

Viele Unternehmen verbringen gleichermaßen viel Zeit damit, sich mit Inferenz-Anwendungen und KI-Modellen zu beschäftigen. Schließlich kann der Wert, der beim Training oder bei der Feinabstimmung eines Modells generiert wird, nur dann ausgeschöpft werden, wenn man damit beginnt, Geschäftsprozesse zu verändern. Diese Herausforderungen, die vor allem in kundenorientierten Szenarien auftreten, umfassen verschiedene Aspekte.

1. Die Kapazität des Modells

Sobald ein Unternehmen ein KI-Modell erprobt hat und mit seinem Verhalten zufrieden ist, muss es dieses in großem Umfang einsetzen. Dabei soll

- die Latenzzeit zwischen dem Benutzer und dem Modell minimiert werden,

- eine angemessene Bandbreite bereitgestellt werden; dies ist besonders wichtig für multimodale Modelle, und

- sichergestellt werden, dass angemessene GPU-Ressourcen zur Verfügung stehen.

Alle drei Faktoren sind entscheidend, um die Reaktionsfähigkeit des eingesetzten Modells zu gewährleisten, insbesondere bei steigender Nutzung.

Die Partnerschaft zwischen Vapor, Supermicro und Nvidia soll in die Kette für möglichst lückenlos gestalten. Sie sprechen von „Zero Gap“. Vapor IO kann durch die Nutzung der „Kinetic Grid-Plattform“ den Zugang zu mehreren Standorten in 36 Städten der USA mit „Supermicro MGX“-Servern, die mit mit „Nvidia GH200 Superchips“ ausgesattet sind und mit niedriger Latenz ermöglichen.

Ganz gleich, ob es sich um ein Krankenhaus, ein Einzelhandelsgeschäft, eine Fabrik oder ein Lagerhaus, ein Unterhaltungszentrum oder eine Stadtverwaltung handelt: Es sei möglich, ein Erlebnis zu bieten, als ob GPU-basierte Server in der eigenen Einrichtung vor Ort wären, ohne sich mit den damit verbundenen Kopfschmerzen auseinandersetzen zu müssen. Und es sei sichergestellt, dass das Netzwerk von Vapor IO mit seiner extrem niedrigen Latenz in der Lage ist, die Nachfrage zu befriedigen, indem es GPU-Ressourcen in der Nähe nutzt, wenn die Auslastung steigt.

2. Verfügbarkeit von Unternehmensdaten für die Erweiterung des Abrufs

Die nächste große Herausforderung ist die Verfügbarkeit von Daten aus der realen Welt. Generative KI ist sehr überzeugend, manchmal sogar zu überzeugend. Daher sind KI-Modelle für viele Anwendungsfälle am nützlichsten, wenn sie mit 'Retrieval Augmented Generation' (RAG) arbeiten. RAG ermöglicht es KI-Modellen, externe Daten mit dem beim Training erworbenen Wissen zu kombinieren, um genauere und zuverlässigere Antworten zu generieren.

Die Herausforderung bei RAG besteht darin, dass man oft Zugang zu einer großen Menge von Daten benötigt, die sich unter Umständen dauernd ändern. Hier kann die Vast-Datenplattform in mehrfacher Hinsicht helfen. Erstens bietet sie ein unternehmenseigenes Repository für Kundendaten in jeder Zero-Gap-Stadt. Der Hersteller bietet mehrere Möglichkeiten, Daten auf der Plattform abzurufen, von traditionellen Datei- und Objekt-Schnittstellen bis hin zu moderneren Ansätzen wie dem direkten Streaming von Daten mit Hilfe von „Kafka“.

Anschließend können diese Daten schnell zur Aktualisierung einer Vektor-Datenbank verwendet werden, die das KI-Modell wiederum sehr effizient durchsuchen kann. Schließlich sorgt der „Vast Dataspace“ dafür, dass alle Standorte auf dieselben Daten zugreifen können, ohne sie ständig replizieren zu müssen. Das bedeutet, dass Unternehmen, die RAG-fähige KI-Modelle auf Zero Gap eingesetzt haben, Antworten auf der Grundlage von im ganzen Land gesammelten Daten geben können, ohne dass das Modell verlangsamt wird.

3. Verfolgung von Aufforderungen und Antworten

KI ist von Natur aus nicht-deterministisch. Stellt man einem generativen KI-Modell 20 Mal dieselbe Frage, erhält man mindestens dieselbe Anzahl an verschiedenen Antworten. Aus diesem Grund ist es von entscheidender Bedeutung, alle Aufforderungen und Antworten an und von einem eingesetzten KI-Modell zu verfolgen. Dies gilt unabhängig von der Modalität: Text, Sprache, Bilder und Videos müssen alle gespeichert werden.

Außerdem besteht der Einsatz eines KI-Modells in den meisten Fällen aus mehreren Modellen. Eines davon ist ein generatives Modell, das die anfängliche Antwort ausarbeitet. Es wird jedoch in der Regel von traditionelleren ML-Modellen begleitet, die den Dialog auf Dinge wie Stimmung (ist der Kunde zufrieden oder frustriert?) und Geschäftsrisiken (gibt das Modell vertrauliche Daten preis oder macht es Versprechungen, die es nicht machen sollte?) untersuchen.

Die Speicherung und Verwaltung all dieser Daten ist an einem oder zwei Standorten eine Herausforderung, ganz zu schweigen von Dutzenden oder Hunderten. Hier kommt die Vast-Datenbank zur Hilfe. Sie bietet die Möglichkeit, strukturierte, tabellarische Daten zu speichern.

Darüber hinaus verfügt Vast über Integrationen mit Tools wie „Apache Spark“, mit denen Benutzer innerhalb von Sekunden Tabellen-Scans durchführen oder Projektionen aus Milliarden von Zeilen erstellen können. Durch die Nutzung der VAST-Datenbank zur Speicherung von Prompt, Antwort, Benutzer, Modell, Vektor-DB und vielen anderen Details, genießen die Nutzer der Zero-Gap-KI-Plattform eine vollständige Rückverfolgbarkeit aller KI-Vorgänge.

4. Modell-Repository und Versionierung

KI-Modelle sind nicht anders als der Code, den Unternehmen in ihren Anwendungen einsetzen. Es werden mehrere Versionen gleichzeitig in Gebrauch sein.

Ein Beispiel mit „Llama3“: Wenn ein Unternehmen ein Modell auf der Grundlage von „Llama2“ implementiert hat, wird es höchstwahrscheinlich eine Version dieses Modells auf der Grundlage von Llama3 testen. Wenn dieses Pilotprojekt gut läuft, wird das Unternehmen mit der Einführung beginnen wollen. Noch wichtiger ist, dass zwei Kopien der Vektor-Datenbank benötigt werden, je nachdem, welches Modell im Einsatz ist, weil sich die vorhandenen Einbettungen wahrscheinlich zwischen den Modellen geändert haben, wenn RAG verwendet wird.

Vapor IO und Vast machen diesen Prozess einfach. Mit den Werkzeugen von Vapor IO und dem Vast Dataspace und dem „Vast-Katalog“ können Benutzer nicht nur viele verschiedene Versionen ihrer Modelle haben, sondern auch ein vollständiges Audit-Protokoll darüber, welche Modelle an welchen Standorten mit welchen Datenquellen verwendet werden.

5. Modell-Sicherheit

Würde also ein Unternehmen seine eigenen Umgebungen für die Modell-Bereitstellung einrichten, wäre dies ein extrem langsamer, mühsamer und teurer Prozess. Daneben würde dies ein erhebliches Hindernis für die Einführung von KI bedeuten. Gleichzeitig sollte die Notwendigkeit, diese Umgebungen zu sichern, nicht unterschätzt werden. Es müssen nicht nur alle Rohdaten verschlüsselt und der Zugriff darauf kontrolliert werden, sondern es besteht auch die Gefahr, dass ein heimtückischer Akteur KI-Modelle missbraucht, um sich als das Unternehmen auszugeben und sehr schnell Schaden anzurichten.

„Zero Gap AI“ ist eine mandantenfähige Plattform, die diese Bedenken ausräumen kann, indem sie einen Zero-Trust-Ansatz für die Sicherheit von KI-Modellen verwendet. Angefangen bei der physischen Ebene wird der Zugang zu den Einrichtungen streng kontrolliert, was zu Sicherheitsmaßnahmen auf Netzwerkebene führt, die eine vollständige Isolierung des Datenverkehrs zwischen den Mietern gewährleisten. Dies wird durch den Einsatz von gehärteten Betriebssystemen, Trusted Platform Modules (TPMs) und sicheren Software-Stücklisten weiter verstärkt, um die Betriebsumgebung vor Kompromissen zu schützen.

Die Nutzung von Tenant-Identitätssystemen und externen Schlüssel-Managern stellt sicher, dass jeder Mandant die Kontrolle über seine Benutzer und Daten behält. Darüber hinaus wird durch die Bereitstellung unveränderlicher Snapshots gewährleistet, dass historische Daten den gesetzlichen Aufbewahrungs-Standards entsprechen.

Auch alle Datenzugriffs-Vorgänge werden umfassend geprüft. Die aktive Überwachung durch maschinelles Lernen ermöglicht es, verdächtiges Verhalten schnell zu erkennen und unter Quarantäne zu stellen. Durch die Zusammenarbeit von Vapor IO, Supermicro, Nvidia und Vast erhalten Unternehmen Zugang zu einer KI-Modell-Serving-Plattform der Enterprise-Klasse zu einem Preis, der eine einfache Einführung ermöglicht.

(ID:50031350)

:quality(80)/p7i.vogel.de/wcms/c0/40/c040b3e689fde1f64258363407e43749/0118721906v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/d2/ce/d2ce7c5846a80c18704c7b1308f817ee/0118017565v4.jpeg)

:quality(80)/p7i.vogel.de/wcms/1f/5b/1f5b7f2adb3e172c396b6a823ffae2da/0118667315v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/7e/4c7e190f635261ad42672dfbca6f622b/0118664304v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ac/b7/acb70a1cdeef61e1bccd78f238c757d4/0118720425v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/b3/38/b33875f0b5ff150a699675edb70ce258/0118693265v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/12/1d/121d1e05365cedf700b4fe512763f56a/0118658919v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/04/74049e872764a52ec1323ea8cb93d285/0118744826v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/3d/e9/3de95062e6e0094ee531aedcfdfee4d0/0118714689v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ff/d1/ffd1d3bdec4875c415cc3aadf7af571b/0118741359v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/62/16/6216aeef7718f98acfc588f579ce48d4/0118679853v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/ff/99/ff990ca056cc773145435e2d7a29ea04/0118760035v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/48/3a/483affc04b1b6abd0a5072cbd74c7aa0/0118761213v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/88/a5/88a5a1a5dfa32204433c4d2b4ca98ed8/0118760980v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b6/08/b608e039fc95fa21954a7e85a6fbcaef/0118516838.jpeg)

:quality(80)/p7i.vogel.de/wcms/d9/4c/d94ca54a155b8144d5b0d37d5ed9cddb/0118499333.jpeg)

:quality(80)/p7i.vogel.de/wcms/7e/47/7e476304931517cad77893d611279a23/0118467374.jpeg)

:quality(80)/p7i.vogel.de/wcms/06/62/0662c81031b4ba04c98a150f2d186f1f/0118466837.jpeg)

:quality(80)/p7i.vogel.de/wcms/f8/2d/f82d4770d04907cd6971ece3a0c5f923/0118489314.jpeg)

:quality(80)/p7i.vogel.de/wcms/e0/37/e0378d057c3622cb1302188f86e1d74f/0118198335.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/3d/c23d0c89b53e4e5bc4e677d202e4f84f/0118163317.jpeg)

:quality(80)/p7i.vogel.de/wcms/72/e4/72e41b05864364407e6c6a43c5ef3db5/0117822809.jpeg)

:quality(80)/p7i.vogel.de/wcms/ea/03/ea0308448142c461be60aa6f06210c05/0115197813.jpeg)

:quality(80)/p7i.vogel.de/wcms/f8/f0/f8f0875d2479f6e260a8234e20446058/0117870929.jpeg)

:quality(80)/p7i.vogel.de/wcms/5b/90/5b9077c213fc5cc0e999093e1b690e3a/0117206477.jpeg)

:quality(80)/p7i.vogel.de/wcms/c4/c4/c4c4a34b823f39aac9b2a41f45d2763a/0117007080.jpeg)

:quality(80)/p7i.vogel.de/wcms/06/7a/067a5d90602fe3f07601605868ccd694/0117793117.jpeg)

:quality(80)/p7i.vogel.de/wcms/bb/80/bb80be0c5bd76440174fa8736c0fc68a/0109079523.jpeg)

:quality(80)/p7i.vogel.de/wcms/90/40/904072c10c6cfb25aa589ccdc2b731a0/0105957803.jpeg)

:quality(80)/p7i.vogel.de/wcms/28/91/2891191f43d783185e01b7838e3ae6cd/0105726161.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/da/f3dacd38e5834ae3f3c9d0a4bc9664d3/0113348475.jpeg)

:quality(80)/p7i.vogel.de/wcms/90/f5/90f56ec6cb3ddbdabca2162fd5477836/0113078524.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/09/0f097990002b7600075e43c92af4a3fd/0110524571.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/ae/66ae9e32738784b57e2ad8c1a4b0986f/0109756744.jpeg)

:quality(80)/p7i.vogel.de/wcms/e9/43/e943e7620868deb3044ba5c8555224b5/0118761251v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/8a/c28a3e2b1e5a668e85a60ab1513f0505/0114961639.jpeg)

:quality(80)/p7i.vogel.de/wcms/51/6b/516b6a7be304ba9862e972c6e11c9fec/0114109625.jpeg)

:quality(80)/p7i.vogel.de/wcms/e3/09/e3096d6dce558738c51c5ca878041061/0107846251.jpeg)

:quality(80)/p7i.vogel.de/wcms/d0/4e/d04ed61cedb2e95dd4239fe7dc09da1c/0107796204.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/5f/74/5f7479b1443af/panduit-logo2015-bp-below-aligned-tm.jpg)

:fill(fff,0)/p7i.vogel.de/companies/64/e4/64e4be0db6ddc/rittal-4c-w.png)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/57100/57113/65.jpg)

:quality(80)/p7i.vogel.de/wcms/f4/11/f411b017c95618b30861247c1e51227e/0117150980.jpeg)

:quality(80)/p7i.vogel.de/wcms/f0/e1/f0e1b550e76d395594b7ca1a050a597a/0114825555.jpeg)