Vom Mythos zur revolutionären Technologie – Eine kurze Geschichte der KI

Die Geschichte der KI gleicht dem Auf und Ab von Börsenkursen. Maßgebliche Treiber: Großkonzerne und das Militär. Dabei währte der Vorsprung verschiedenster Ansätze in der Regel nur kurz.

Hamburg. Die Erschaffung einer Künstlichen Intelligenz (KI) ist ein jahrhundertealter Traum. Spätestens seit der Antike wünschten Menschen sich eine Entsprechung ihrer selbst. Die griechische Mythologie kannte einen 30 Meter großen Humanoiden namens Talos, der die Insel Kreta beschützte. Im Mittelalter nahmen Legenden wie die des Golem, der mitunter einer aus Lehm geformten Mensch-Maschine glich, das Konzept eines denkenden Gegenstands vorweg.

Konkret wurde es erst im 20. Jahrhundert. Der durch die Weltkriege entstandene Forschungsdruck sowie die Revolution der Elektronik machten Maschinen möglich, die zuvor kaum vorstellbar erschienen.

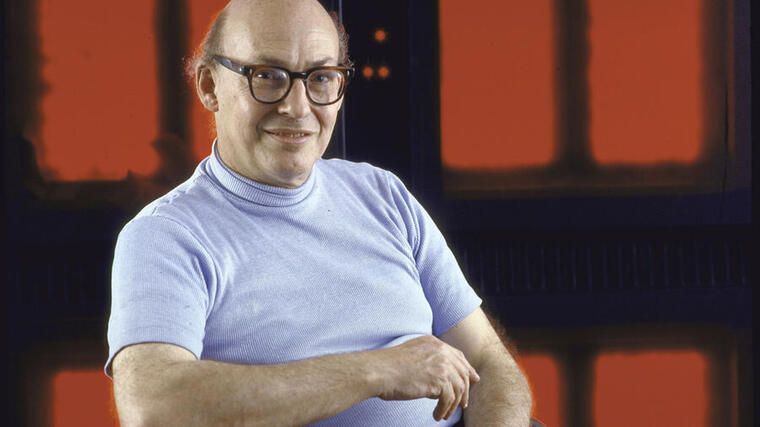

Die Geschichte der KI, die sich über die folgenden Jahrzehnte spannt, verlief dabei meist zyklisch: Phasen des Booms wechselten sich mit ernüchternden „KI-Wintern“ ab, in denen es dem Feld an Unterstützung und Geld fehlte. Forscher wie Marvin Minsky, die in gerade diesen Phasen weitermachten, haben ihre Disziplin oft am weitesten vorangebracht.

Jetzt Handelsblatt Premium zum Vorteilspreis sichern - Zum Angebot

1940 bis 1979: Turing-Test und künstliche Psychotherapeuten

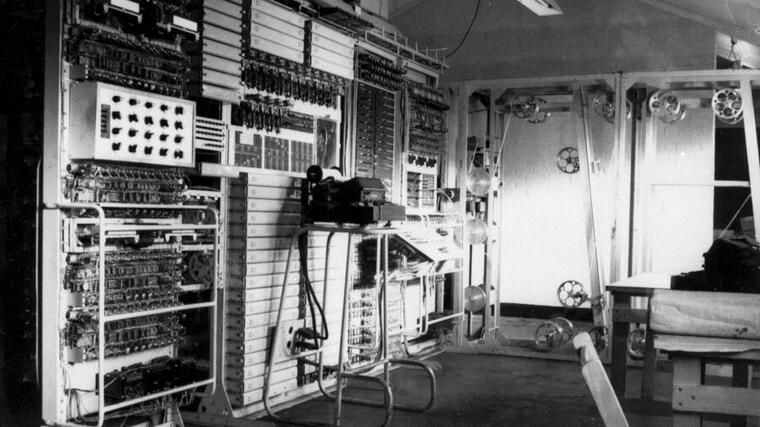

Die Ära der KI im engeren Sinn begann im England der 1940er-Jahre. Dort legte der Mathematiker Alan Turing mit seinen Dechiffriermaschinen („Enigma“) während des Zweiten Weltkriegs die Grundlagen komplexer Rechner, wie wir sie heute kennen. Menschen, so Turing, nutzen Informationen und Logik, um Probleme zu lösen und Entscheidungen zu treffen. Warum sollten Maschinen nicht ebenso vorgehen können?

In seinem Artikel „Computing Machinery and Intelligence“ entwarf der Brite im Jahr 1950 seinen berühmt gewordenen Turing-Test, dessen Resultat den Schluss erlaubt, ob eine Maschine „denken“ kann oder nicht. Intelligent ist ein Computer demnach erst dann, sobald ein neutraler Beobachter in einem textbasierten Austausch zwischen Mensch und Rechner nicht mehr klären kann, wer von beiden die Maschine ist. Bis heute werden KI-Systeme mitunter danach beurteilt – auch wenn viele Experten ihn mittlerweile für überholt halten.

An eine Umsetzung war damals jedoch noch nicht zu denken. Die frühen Computer der Nachkriegsära konnten nicht mal kleinste Datenmengen speichern.

Als formale Geburtsstunde der Disziplin gilt eine kleine Konferenz von 1956 am Dartmouth College im US-Bundesstaat New Hampshire. Dort präsentierten Forscher den „Logic Theorist“ – einen Computer, der mathematische Probleme auf ähnlichem Wege löste wie ein Mensch.

Die Konferenz, organisiert von John McCarthy und KI-Pionier Minsky, wurde zum Schlüsselevent. Die relevanten Köpfe der Zeit trafen dort erstmals aufeinander. McCarthy hatte erst ein Jahr zuvor den damals noch nicht geläufigen Begriff „Künstliche Intelligenz“ geprägt.

In den folgenden Jahrzehnten kam den Forschern die rasante Entwicklung der Computerchips zupass, die immer größere Mengen an Daten verarbeiten konnten. Vor allem in den USA flossen Milliarden an Fördergeldern, da Regierung wie Militär auf große Durchbrüche hofften. Initiativen wie das US-Projekt „Eliza“, das einen Psychotherapeuten simulierte, zielten direkt auf Turings Vision einer sprechenden Maschine.

Jetzt Handelsblatt Premium zum Vorteilspreis sichern - Zum Angebot

Auf den weitgehend öffentlich finanzierten KI-Boom ab 1960 folgte dann der erste Abschwung ab Mitte der 1970er-Jahre.

1980-2002: Expertensysteme sparen Millionen, und „Deep Blue“ gewinnt im Schach

Dieser „KI-Winter“ endete erst 1980 mit Aufkommen der sogenannten Expertensysteme. Die Maschinen wurden schrittweise mit Spezialwissen einer Disziplin gefüttert, bis sie selbstständig auf Fragen antworten konnten. So half das Programm Xcon des Computerherstellers DEC bei der Konfiguration aufwendiger Rechnersysteme. Geschätzte Ersparnis: 25 Millionen Dollar pro Jahr. Die Regierungen in London, Washington und Tokio riefen in Folge jeweils eigene, mehrere Hundert Millionen Dollar teure Forschungsprojekte ins Leben.

Nach einer weiteren Phase enttäuschter Investorenhoffnungen begann 1993 die Ära der privat finanzierten KI-Projekte – was die technische Entwicklung durchaus beförderte. Fortschritte in der Chiptechnologie machten neue Ansätze möglich.

Großkonzerne und selbst Start-ups wie das damals noch kleine Google waren bald in der Lage, günstig und schnell mehrere Hundert Gigabyte an Daten zu speichern und zu verarbeiten. Zum Vergleich: Eine durchschnittliche Festplatte hatte noch Mitte der 1990er-Jahre eine Kapazität von lediglich ein paar Hundert Megabytes.

Als Meilenstein stach seinerzeit IBMs „Deep Blue“-Rechner hervor, der 1997 den Schachmeister Garri Kasparow besiegte.

2003 bis heute: Deep Learning und der Grundstein für ChatGPT

Die Grundlagen der generativen KI-Ansätze à la ChatGPT legte ab 2003 unter anderem ein Team um die Forscher Geoffrey Hinton, Yoshua Bengio and Yann LeCun, die als „Paten des Deep Learnings“ in die Geschichte eingingen. Das Trio legte seinerzeit ein Forschungsprojekt mit dem Ziel auf, die neuronalen Netze des Gehirns im Computer nachzuahmen. Dieser Ansatz prägt die Szene bis heute.

LeCun wechselte später zum Facebook-Konzern Meta, Hinton heuerte 2013 bei Google an, wo er das KI-Projekt Brain leitete. Google Brain wurde Anfang dieses Jahres mit dem ehemaligen britischen Start-up Deep Mind zusammengelegt, das Google bereits 2014 übernommen hatte. Deep Minds Software „AlphaGo“ sorgte ab 2015 für Aufsehen, weil sie in der Lage war, mehrere Meister des asiatischen Brettspiels Go zu bezwingen. Zuvor waren Computer an der Komplexität des Spiels gescheitert.

Deep Learning ist in seinen verschiedenen Spielarten nach wie vor maßgebend. Nach einem Training mit großen Datenmengen – die als „Big Data“ bald auch Eingang in die Sprache der Wirtschaft fanden – kann die Software selbstständig Schlüsse ziehen. Die Genauigkeit von Bild- wie Spracherkennung wurde so entscheidend verbessert.

Darauf aufbauend entwickelten Experten ab 2017 die ersten Transformer-Modelle, die etwa Texte von einer Sprache in eine andere übersetzen konnten. Sie bilden die Grundlage der sogenannten Generative Pretrained Transformer (GPT), mit denen auch das von Sam Altman geführte OpenAI seit Ende 2022 Furore macht.

OpenAI-Dienste wie ChatGPT oder die Bildgenerierung DALL-E machten der Öffentlichkeit auf einen Schlag die großen Fortschritte bewusst, die KI-Technologie vor allem dank neuartiger, besonders leistungsfähiger Chips gemacht hatte.

Diese „GPUs“ wurden ursprünglich dazu entwickelt, Computerspiele realistischer aussehen zu lassen. Der kalifornische Hersteller Nvidia beherrscht den weltweiten GPU-Markt und steigerte so kürzlich seine Börsenbewertung auf mehr als eine Billion US-Dollar. Berichten zufolge sollen allein für die Entwicklung von ChatGPT mehr als 10.000 der Spezialchips nötig gewesen sein.

OpenAI, 2015 ursprünglich als gemeinnützige Gesellschaft gegründet, brachte die jüngste, vierte Version seines gefeierten Sprachmodells GPT im vergangenen März auf den Markt. Der Nachfolger ist bereits in Vorbereitung.

Einige Experten erwarten jedoch, dass der Vorsprung von Pionieren wie OpenAI oder Google, das mit Bard ein eigenes Sprachmodell anbietet, nicht von Dauer ist. Öffentlich verfügbare Konkurrenzangebote könnten ihnen demnach schon bald den Rang ablaufen.

Jetzt Handelsblatt Premium zum Vorteilspreis sichern - Zum Angebot

Jetzt Handelsblatt Premium zum Vorteilspreis sichern - Zum Angebot